Smart Factory braucht smarte Infrastruktur

Von Falko Binder, Cisco

Ein Fertigungsunternehmen lebt von der Effizienz und Stabilität des Herstellungsprozesses. Für den Unternehmenserfolg m Rahmen von Industrie 4.0 spielt aber die IT-Infrastruktur eine zunehmend tragende Rolle. Durch die Auswertung von Sensordaten und vorausschauende Analyse lassen sich zum Beispiel IT-Fehler frühzeitig vorhersagen, Risiken vermeiden, Hackerangriffe abwehren und Wartungskosten reduzieren. Das Fundament dafür bildet allerdings ein hochleistungsfähiges Netzwerk, das für die Herausforderungen des IIoT (Industrial Internet of Things) ausgelegt ist.

Dazu gehört neben Agilität und Skalierbarkeit vor allem Big-Data-Fähigkeit. Denn bei der Industrie 4.0 entsteht durch die enorme Anzahl an Sensoren und die umfassende Vernetzung eine riesige Datenmenge, die das Netzwerk quasi in Echtzeit an zentrale Rechenzentren übertragen muss. Dies stellt eine solche Herausforderung dar, dass alternative Konzepte wie Edge Computing entwickelt wurden. Hier findet eine erste Analyse der Rohdaten auf dem Endgerät selbst oder auf einem Server in der Nähe statt, damit erste Auswertungen und damit deutlich weniger Daten an die zentralen Rechenzentren geschickt werden.

Very Big And Dangerous Data

Big Data stellt die Basis für analytisch fundierte Entscheidungen im Produktionsprozess dar, und zwar für die komplette vernetzte Wertschöpfungskette vom Design über die Entwicklung bis zur Produktion. Dies gilt von Detailfragen, zum Beispiel wann eine Maschine idealerweise gewartet werden sollte, bis hin zum strategischen Gesamtkonzept. Schließlich verfolgen Fertigungsunternehmen im Zuge von Industrie 4.0 mehr und mehr datenbasierte Geschäftsmodelle. Dafür erhalten sie mehr technologische Möglichkeiten zur Datenerhebung, -auswertung und -speicherung. Durch die zunehmend vernetzte Produktion können sie dann etwa Fehlfunktionen frühzeitig vorhersagen oder die Fertigungsstraße schnell zur Herstellung neuer oder veränderter Produkte umstellen.

Allerdings entsteht auch eine große Gefahr: Durch die immer umfangreicheren Datenmengen werden Produzenten auch immer attraktiver für Hacker und Spione. Diese können über die direkte oder indirekte Vernetzung des Shopfloors mit dem Internet auf sensible Informationen zugreifen. So sind zum Beispiel Konstruktionszeichnungen direkt mit dem CNC-System gekoppelt, und dieses wird direkt mit Produktionsdaten gefüttert. Doch intelligente Systeme können auch solche Angriffe abwehren, indem sie Anomalien oder Verletzungen der Zugriffsrechte erkennen.

Intelligenz auf Shopfloor-Ebene

Zwar beschäftigen sich viele Unternehmen mit Automatisierung und datenbasierter Analyse. Aber um Big Data sinnvoll zu nutzen, benötigen sie ein Netzwerk, das die Anforderungen des IoT bewältigen kann. Die größte Herausforderung stellt dabei die stark steigende Zahl der vernetzten Geräte. Laut Cisco VNI Report (Visual Networking Index) müssen Netzwerkingenieure, die sich bereits heute um Hunderte von Geräten kümmern, bis 2020 voraussichtlich eine Million Geräte verwalten. Dies lässt sich nur mit Unterstützung weitgehend automatisierter Netzwerkmanagementlösungen bewältigen.

Ähnliches gilt für die Fertigung: Die Intelligenz der Produktionsanlagen sitzt in Zukunft nicht mehr ausschließlich in den zentralen Steuerungsmodulen und Verwaltungssystemen, sondern verlagert sich direkt in die Maschinen. Denn dort befinden sich nicht nur immer mehr Sensoren, sondern auch zunehmend intelligente Programme für erste Analysen und Steuerungsfunktionen. Die Erfassung dieser Informationen, zum Beispiel zu Maschinenkonformität und Produktverschleiß, führt jedoch zu einer hohen Datendichte. Diese muss durch entsprechend dimensionierte Lösungen bewältigt werden, um die Weiterleitung und Analyse in Echtzeit zu gewährleisten.

Schwarz auf Weiß

Dieser Beitrag erschien zuerst in unserer Magazinreihe „Rechenzentren und Infrastruktur“. Einen Überblick mit freien Download-Links zu sämtlichen Einzelheften bekommen Sie online im Pressezentrum des MittelstandsWiki.

Das Netzwerk ist die Basis

Daher sind in vielen Fällen neue, leistungsstärkere Netzwerkkomponenten notwendig. Diese sollten nicht nur anhand der aktuellen Performance-Anforderungen dimensioniert werden, sondern mit Blick auf die weiter steigenden Datenmengen in den kommenden Jahren. Hinzu kommt aus Sicherheitsgründen die Verschlüsselung von Daten, die zusätzliche Leistung erfordert. Ergänzend ist eine zuverlässige Netzwerkinfrastruktur mit hohen Bandbreiten nötig.

Diese Anforderungen führen bei zahlreichen Unternehmen zu einer Loslösung von den bisherigen hardwarebasierten Konzepten. Denn diese bieten meist nicht die notwendige Flexibilität und Skalierbarkeit, die im IoT-Zeitalter nötig ist – schon gar nicht zu vertretbaren Kosten. Daher kommen zunehmend softwarebasierte Konzepte zum Einsatz. Hier befindet sich die Steuerungsebene von Netzwerkkomponenten nicht mehr auf den Geräten selbst, sondern in zentralen Anwendungen. Auf diese Weise lassen sich die Eigenschaften aller Netzwerkgeräte mit einem Knopfdruck ändern – statt manuell an jedem Gerät vor Ort.

Big-Data-Analysen erfordern somit einen neuen Blick auf die genutzte Plattform und die Infrastrukturkapazität. Um ein nachhaltiges System zur Echtzeitdatenanalyse aufzubauen, sind am Frontend hohe Leistung, niedrige Latenzzeiten und hochskalierbare Server notwendig, die mit der Menge und der Geschwindigkeit der Daten und Ereignisse einer großen Anzahl gleichzeitig aktiver Clients mithalten können. Im Bereich Analytik bzw. als Grundlage für Geschäftslogik sind Hochleistungsdatenserver und Middleware erforderlich, die Echtzeitdaten verarbeiten können, und dies mit hohem Durchsatz und auch hier mit geringer Latenzzeit. Bei der Netzwerkinfrastruktur gehören darüber hinaus eine hohe Bandbreite und Paketverarbeitungskapazitäten zu den essenziellen Anforderungen.

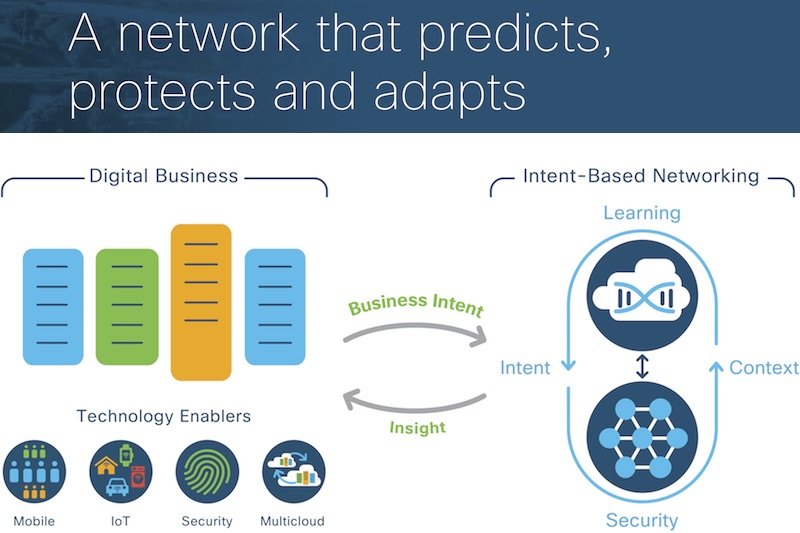

Falko Binder ist Head of Enterprise Networking Architecture Germany bei Cisco. Als weltweit wichtigster Netzwerkausrüster treibt Cisco den digitalen Wandel und die IIoT-Entwicklung maßgeblich voran, unter anderem mit hyperkonvergenten Infrastrukturen und neuen Intent-based Networks.

Cisco Systems, Inc., Corporate Headquarters, 170 West Tasman Dr., San Jose, CA 95134, USA, Tel.: (089) 51657 2000 oder 0800 187 3652, www.cisco.com

Auf dynamische Infrastruktur umstellen

Industrie 4.0 basiert auf der Erfassung und Auswertung großer Datenmengen. Wer Big Data nutzen will, benötigt ein leistungsfähiges Netzwerk, das sich flexibel an neue Anforderungen anpassen kann. Dazu sind die bisherigen statischen Hardwarekonzepte durch dynamische Ansätze zu ersetzen.