Aufgabengenaue KI-Chips

Von Ariane Rüdiger

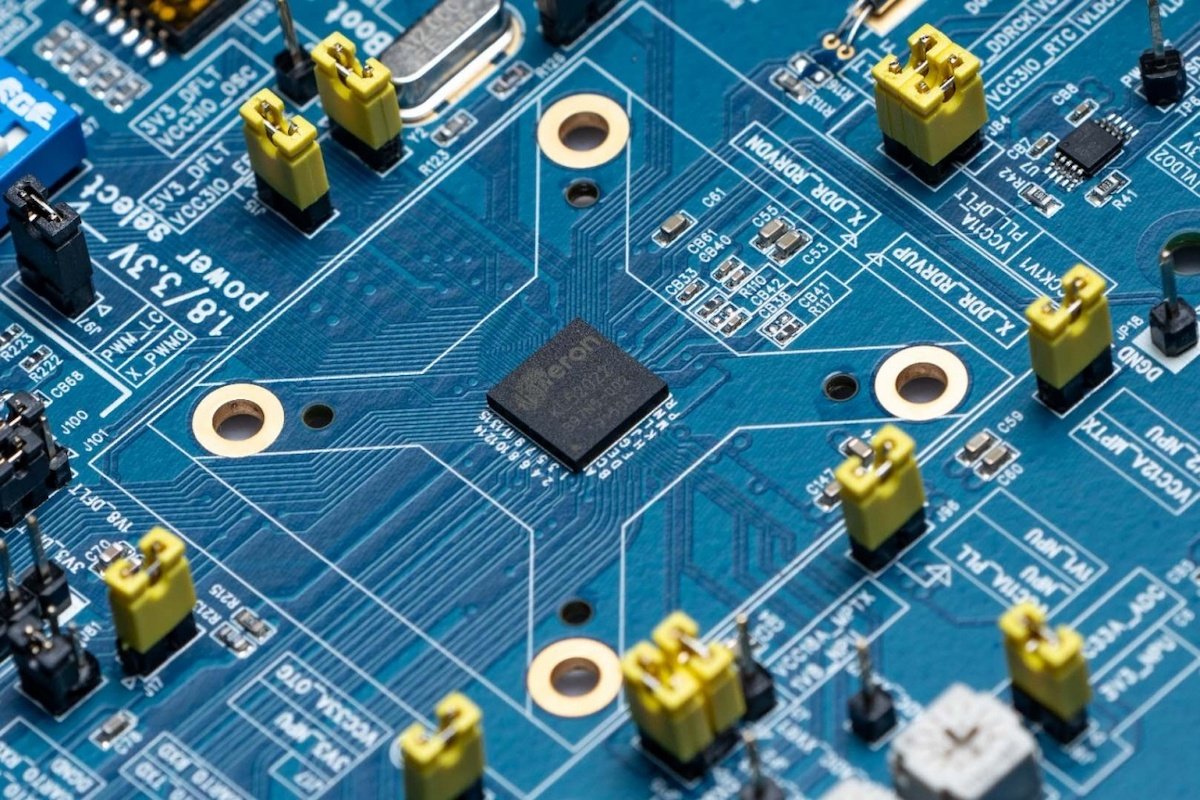

Inzwischen ist es müßig, immer wieder die enorme Menge an Exa- oder Zetabytes an Daten zu beziffern, die in den kommenden Jahren entstehen soll. Für normale Menschen bleiben diese Dimensionen so oder so unvorstellbar. Und durchforstet werden sollen diese Daten so oder so, weil man aus ihnen, wenn möglich, nützliche Erkenntnisse gewinnen will. Doch die heute verfügbare Hardware ist dafür nur sehr teilweise ausreichend.

Überall auf der Welt wird deshalb an neuen Prozessorarchitekturen gearbeitet, die genauer auf spezifische Teilaufgaben aus KI (künstlicher Intelligenz) oder ML (Machine Learning) zugeschnitten sind. Gartner schätzt in einer Studie vom Januar dieses Jahres, dass bis 2023 15 % der Server Prozessoren zur Beschleunigung von KI-Workloads besitzen werden. 2024 sollen die Hälfte aller Midrange- und Highend-Smartphones und ein Viertel aller 5G-Mobilstationen mit KI-Funktionen ausgerüstet sein. Ein weiterer interessanter Aspekt: 2024 sollen schon 40 % der digitalen Überwachungskameras mit intelligenten Chips ausgerüstet sein, die Bilder voranalysieren und nur das weiterschicken, was potenziell wichtige Inhalte dokumentiert.

Rasantes Marktwachstum

Der Weltmarkt für Chips, die neuronale Netzwerke verarbeiten, soll laut Gartner von 34,3 Milliarden Dollar (2023) auf knapp 44 Milliarden Dollar (2024) wachsen. Gartner betrachtet auch die möglichen Anwendungsfelder: Demnach wächst das Marktvolumen in den Jahren 2019–2024 im Industriemarkt um etwa 130 %, im Automotive-Markt um rund 90 %. Dennoch liegt es auch dann erst unterhalb von 5 Milliarden Dollar. Den voluminösesten Markt sieht Gartner 2024 mit mehr als 20 Milliarden Dollar in der drahtlosen Kommunikation.

Laut Gartner werden besonders applikationsspezifische Prozessoren ein großes Marktvolumen erreichen. (Bild: Gartner)

Doch welche Art von Prozessoren kommt für die Aufgaben, die bei Maschinenlernen und sogenannten „tiefen“ neuronalen Netzen (Deep Neural Networks) anfallen, überhaupt infrage? Mittelfristig prognostiziert Gartner sogenannten applikationsspezifischen Standardprozessoren eine besonders glänzende Zukunft. Sie sollen 2024 ein Marktvolumen zwischen 20 und 25 Milliarden Dollar umfassen.

Heute reichen für diverse Aufgaben und KI-Algorithmen, die mit relativ kleinen Datensätzen zurechtkommen, leistungsfähige Standardprozessoren. Dazu gehören etwa die Multicore-Varianten von Intel Xeon, ARM oder auch IBM Power. Deren parallel arbeitende Kerne haben für diese Zwecke genug Rechenkraft.

Anspruchsvollere neuronale Netze dagegen profitieren sowohl in der Lern- als auch in der Inferenzphase von veränderten Prozessorarchitekturen. Inferenz bedeutet, dass neue Daten durch ein bereits angelerntes neuronales Netz gewonnen werden.

GPUs: schnell und parallel, aber ungenauer

Besonders das Training ist als extrem aufwendig und damit auch leistungsfressend verschrien. „Dafür reichen meist die 32 Kerne von Standard-CPUs nicht aus“, meint Chirag Dekate, Senior Researcher bei Gartner. Standard für die Bewältigung dieser Aufgaben sind heute Nvidia-GPUs. Sie und ihr CUDA-Software-Ökosystem respektive die CUDA-APIs werden von den meisten Deep-Learning-Frameworks unterstützt und bieten derzeit die höchste verfügbare Leistung. Bis zu 3600 CUDA-Threads kann eine Nvidia-GPU parallel ausführen. Aktuelle Varianten sind Volta und Turing.

Schwarz auf Weiß

Dieser Beitrag ist zuerst in c’t innovate 2020 erschienen. Die gesamte KI-Strecke aus diesem Heise-Sonderheft gibt online im Pressezentrum des MittelstandsWiki.

Die hohe Leistung der Prozessoren beruht darauf, dass sie zugunsten der Geschwindigkeit die Verarbeitungsbreite herunterfahren. Man bezeichnet dies als Reduced Precision Matrix, es bedeutet das Rechnen mit 16, 8 oder in Zukunft noch geringerer Datenbreite. Dies funktioniert, weil bei vielen Anwendungen keine so große Detailgenauigkeit notwendig ist. „Mittelfristig braucht die Industrie auf jeden Fall neue Herangehensweisen, deshalb versuchen wir, möglichst flexibel zu sein“, erklärt Adam Grzywaczewski, Senior Deep Learning Data Scientist bei Nvidia.

Neben Nvidia spielt auch AMD mit seinen GPUs MI6, MI8 und MI25 sowie seiner neuen Umgebung Radeon Vega und der Plattform ROCm eine Rolle auf diesem Markt. Sie ist jedoch wesentlich geringer als die von Nvidia, konstatiert Gartner.

FPGAs (Field Programmable Gate Arrays, spezielle Gleitkomma-Berechnungseinheiten) werden eher selten verwendet, weil sie zu langsam und in für Deep-Learning-Frameworks eher ungewohnten Sprachen programmiert sind. Eine andere Alternative sind ASICs (Application-specific Integrated Circuits), aber hier konstatiert Gartner fehlende Marktreife. Allerdings haben Googles TensorFlow-Prozessoren TPU v2/3 gezeigt, was in applikationsspezifischer Technik steckt. Schade nur, dass die Daten dafür auf Google verlagert werden müssen.

Vorbild menschliches Gehirn: Intels Loihi arbeitet mit selbstverknüpfenden Silizium-„Neuronen“. (Bild: Intel)

Im Aufholgang befindet sich hier Intel mit seiner Nervana-Prozessorreihe, die Ende 2019 vorgestellt wurde. Sie soll die Arbeit mit ML-Algorithmen erleichtern und in Rechenzentren eingesetzt werden. NNP-T eignet sich für das Anlernen der Algorithmen, NNP-I für die Inferenz. Huawei hat ebenfalls 2019 den sehr leistungsfähigen Prozessor Ascend 910 vorgestellt.

NPUs und Quantencomputer: Das dauert noch

Ganz neue Wege gehen sogenannte neuromorphe Prozessoren. Diese NPUs (Neuromorphic Processor Units) imitieren die Hirnstruktur mit ihren neuronalen Verbindungen und „funkenden“ Neuronen, die in Silizium nachgebaut werden. „Ein bekanntes Beispiel dafür sind der IBM TrueNorth oder Intel Loihi“, erklärt Chirag Dekate. Die größere Geschwindigkeit und der geringere Stromverbrauch dieser Chips haben aber einen Preis: geringere Genauigkeit und kaum Software, da solche Prozessoren eine komplett andere Ausführungslogik brauchen als bisherige Architekturen. Bis diese Prozessoren im Markt eine wichtige Rolle spielen, wird es laut Dekate noch mindestens fünf Jahre dauern.

Das Lawrence Livermore National Laboratory (LLNL) holte sich 2016 den ersten neurosynaptischen Deep-Learning-Chip TrueNorth von IBM. (Quelle: IBM)

Noch viel länger, nämlich zehn Jahre, könnten nötig sein, bis Quantencomputer so weit sind, dass sie für breitere Anwenderkreise bei KI-Themen eine Rolle spielen. Derzeit ist man seitens potenzieller Anwender vor allem damit beschäftigt, in meist kostenlos nutzbaren Testumgebungen Probleme überhaupt in von Quantencomputern verarbeitbaren Algorithmen darzustellen. Forscher auf der Hardwareseite versuchen, die Zahl der Qubits langsam nach oben zu schrauben.

Für Inferenzzwecke sieht Gartner-Analyst Dekate derzeit neben den Nvidia-Chips P40 und P4 vor allem andere GPUs, ASICs und FPGAs als mögliche Alternativen. Die Nutzung von Nvidia ist allerdings teuer – laut Gartner um 50 bis 60 % teurer als ASICs. Seit Mai 2019 ist der Ethos-N77 von ARM auf dem Markt, der ebenfalls auf Inferenz spezialisiert ist. Zu den ASICs wiederum gehören Produkte wie Googles TPU oder aber Graphcore. Graphcores IPU (Intelligent Processing Unit) gibt es seit 2018 in ein System von Investor Dell integriert zu kaufen.

Größenvergleich mit einem Eishockey-Puck: Der Riesenprozessor von Cerebras enthält 400.000 KI-Cores und sprengt bisherige Standardwaferformate. (Bild: Cerebras Systems)

Start-ups auf der Überholspur

Der Run auf künstliche Intelligenz hat außerdem neue Player auf den Markt gelockt. So präsentierte sich im Sommer 2019 auf einer Konferenz in Stanford das Start-up Cerebras mit einem extrem großen Prozessor für das Anlernen von neuronalen Netzen. Der Chip umfasst 400.000 KI-Cores, 1,2 Trillionen Transistoren und 18 GByte RAM.

Das Silicon-Valley-Start-up Groq hat einen neuartigen Tensor-Streaming-Prozessor (TSP) entwickelt. Eine neuartige Mikroarchitektur und ein neuer Compiler sollen dafür sorgen, dass die vorhandenen Transistoren ausgelastet werden. Über die Genauigkeit macht Groq keine Angaben. Die Leistung soll bei 1 PetaOPS liegen, das sind 1000 Tera-Operationen pro Sekunde.

Die Tensorverarbeitungseinheit von Groq schafft bis zu 1 PetaOPS. (Bild: Groq, Inc.)

Speziell für IoT-Umgebungen mit KI-Datenverarbeitung sollen sich die Prozessoren von GreenWaves Technologies eignen. Das aktuelle Produkt heißt GAP9. Die Prozessoren sind auf die Verarbeitung von Bildern, Tönen und taktilen Informationen zugeschnitten und verbrauchen nur sehr wenig Energie.

Ebenfalls fürs Edge ist die Prozessorreihe KDP x20 von Kneron gedacht. Das Start-up wird von der chinesischen Online-Plattform Alibaba gefördert. Die Leistungsaufnahme des Kneron-Chips soll nur 0,3 bis 0,5 W betragen. Die KDP-x20-Chips erreichen laut Hersteller 5,8 TeraOPS.

Interessant könnten auch Entwicklungen rund um die Spezifikation von RISC-V werden. Die Spezifikation der fünften Generation der befehlssatzreduzierten Prozessorklasse macht nur wenige Vorgaben und ermöglicht Add-ons, die das Gesamtdesign auf Spezialaufgaben zuschneiden. Beispielsweise veröffentlichte das Fraunhofer-Institut für Mikroelektronische Schaltungen und Systeme IMS im Herbst 2019 Informationen über ein solches Projekt. „Zusammen mit dem AIfES-Framework für embedded KI haben wir damit ein System für den Einsatz von künstlicher Intelligenz auf sensor- bzw. aktornahen eingebetteten Systemen ermöglicht“, erklärt Alexander Stanitzki vom Fraunhofer IMS.

Momentan dreht sich alles um ChatGTP. Für die Zeit davor gibt eine Einführung einen ersten Überblick über den Stand der Technologien, die Fortsetzungen skizzieren praktische Einsatzgebiete für KI, insbesondere in der Industrie. Für den Lebenslauf könnten die Ratgeber zur KI-Studienstrategie bzw. zum KI-Studium (auch in Kombination mit Robotik) sowie zum Berufsbild Machine Learning Engineer und zum KI-Manager nützlich sein – aber auch die Übersicht zu den Jobs, die KI wohl ersetzen wird.

Extrabeiträge untersuchen, wie erfolgreich Computer Computer hacken, ob und wann Vorbehalte gegen KI begründet sind und warum deshalb die Erklärbarkeit der Ergebnisse (Stichwort: Explainable AI bzw. Erklärbare KI) so wichtig ist. Hierher gehört außerdem der Seitenblick auf Maschinenethik und Münchhausen-Maschinen. Als weitere Aspekte beleuchten wir das Verhältnis von KI und Vorratsdatenspeicherung sowie die Rolle von KI in der IT-Sicherheit (KI-Security), fragen nach, wie Versicherungen mit künstlicher Intelligenz funktionieren, hören uns bei den Münchner KI-Start-ups um und sehen nach, was das AIR-Projekt in Regensburg vorhat. Ein Abstecher führt außerdem zu KI-Unternehmen in Österreich.

Auf der rein technischen Seite gibt es Berichte zu den speziellen Anforderungen an AI Storage und Speicherkonzepte bzw. generell an die IT-Infrastruktur für KI-Anwendungen. Außerdem erklären wir, was es mit AIOps auf sich hat, und im Pressezentrum des MittelstandsWiki gibt es außerdem die komplette KI-Strecke aus dem Heise-Sonderheft c’t innovate 2020 als freies PDF zum Download.